はじめに

はじめまして、22卒のやまけん(@yamaken_0216)です!お仕事ではバックエンドの開発、運用やDBのクエリチューニングなどを行っています。今年の5月ごろに@adachin0817さんと1on1をして、TechBullにジョインし、イベントや飲み会、ペアプロなどに何度か参加させていただいています。今回は、LM Studioを使ってローカルLLMを動かしてみようと思います。非常に簡単に環境構築できるので、参考になれば幸いです!

LM Studioについて

LM Studioは、LLMを手軽に動かせるデスクトップアプリです。GUIでモデルのダウンロードなどの環境構築ができます。環境構築の流れは後述します!

システム要件

Macのシステム要件は以下の通りです。

- チップ: Apple Silicon (M1/M2/M3/M4)。macOS 13.4以降が必要です。

- MLX モデルの場合、macOS 14.0 以降が必要です。16GB以上のRAMを推奨します。

- 8GB の Mac でも LM Studio を使用できる可能性がありますが、小さいモデルと適度なコンテキスト サイズにしてください。IntelベースのMacは現在サポートされていません。

WindowsやLinuxについては、こちらから確認してください。

今回使用するMacのスペック

- MacBook Pro 14 M2 Max

- memory : 64GB

- macOS : Sequoia 15.6

使用するモデルについて

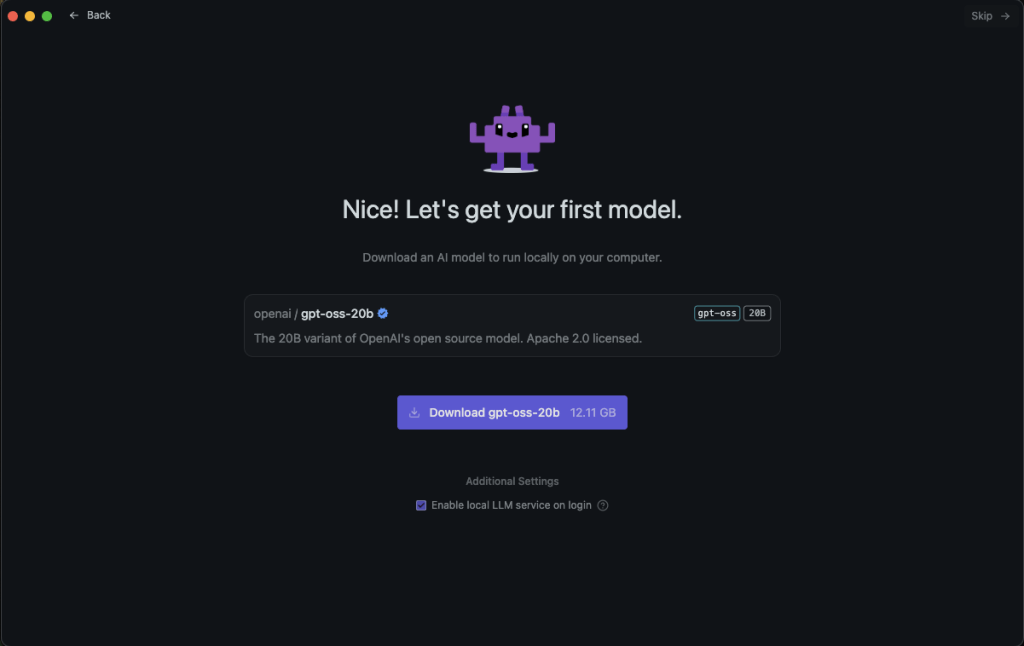

先日公開されたgpt-ossを使用します。gpt-ossには、gpt-oss-120bと gpt-oss-20b の2種類あります。

gpt-oss-120bは、o4-miniと同等程度のベンチマークを示すモデルgpt-oss-20bは、o3-miniと同等程度のベンチマークを示すモデル

今回は、gpt-oss-20bを使用します。

LMStudioの環境構築

LM Studioをダウンロードして、インストールしてください。

1. 立ち上がったら「Get Started」を選択してください。

2. 次に「Developer」を選択します。

3. gpt-oss-20bが提案されるので、ダウンロードします。

(もしモデルのダウンロードが表示されなければ、こちらを参考にしてください。)

4. ダウンロードが完了すると、環境構築完了です。

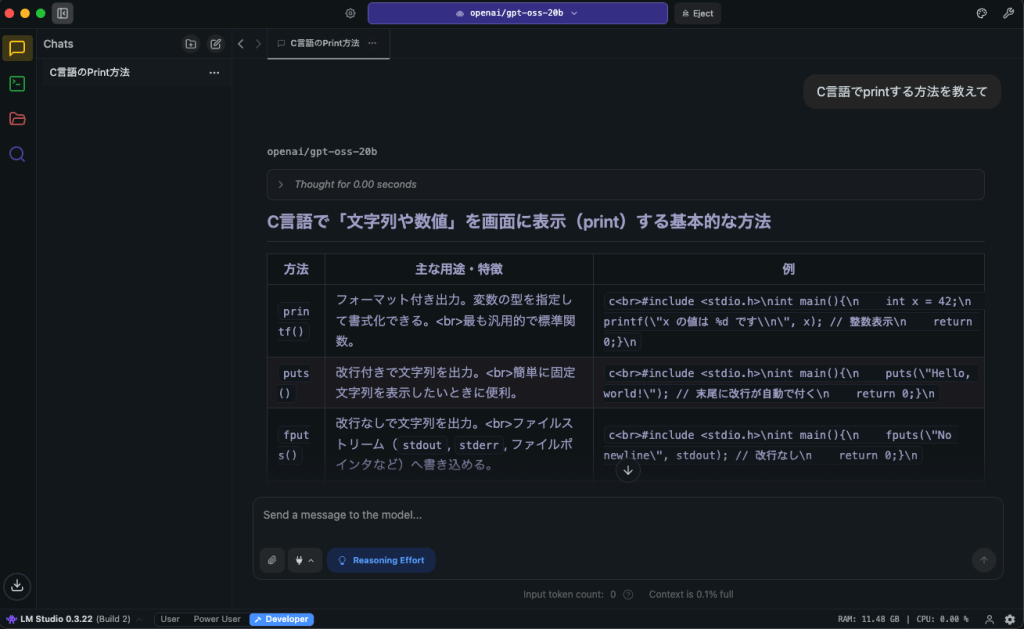

「Start a New Chat」をクリックして実際に使ってみましょう!

LMStudioを動かす

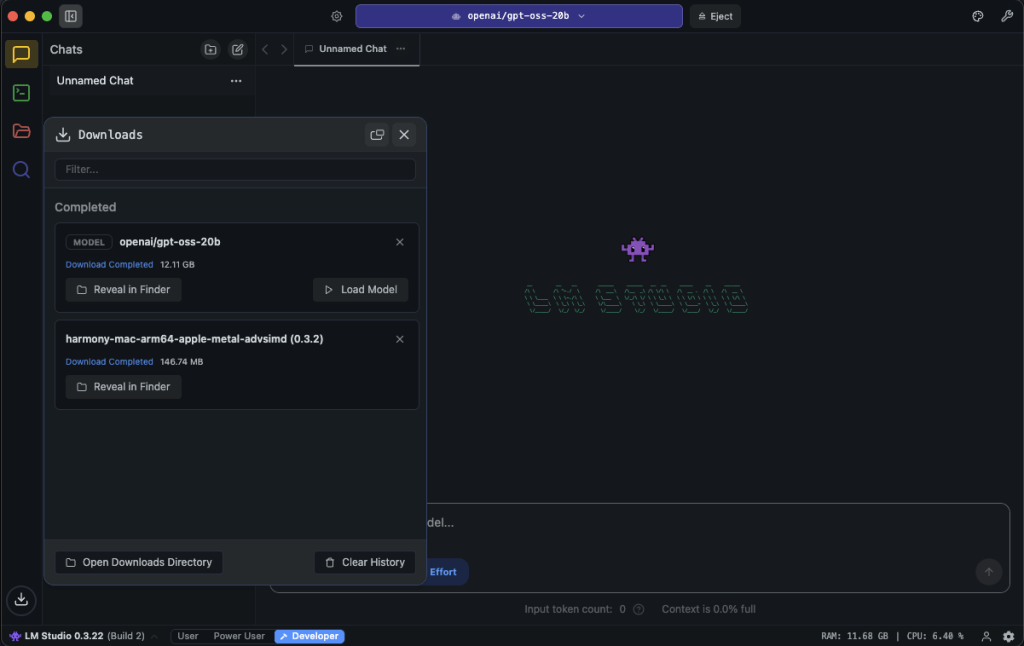

左下のDownloadボタンから、Load Modelをクリックします。

すると、上部に「openai/gpt-oss-20b」と表示され、右下にRAMが確保されます。

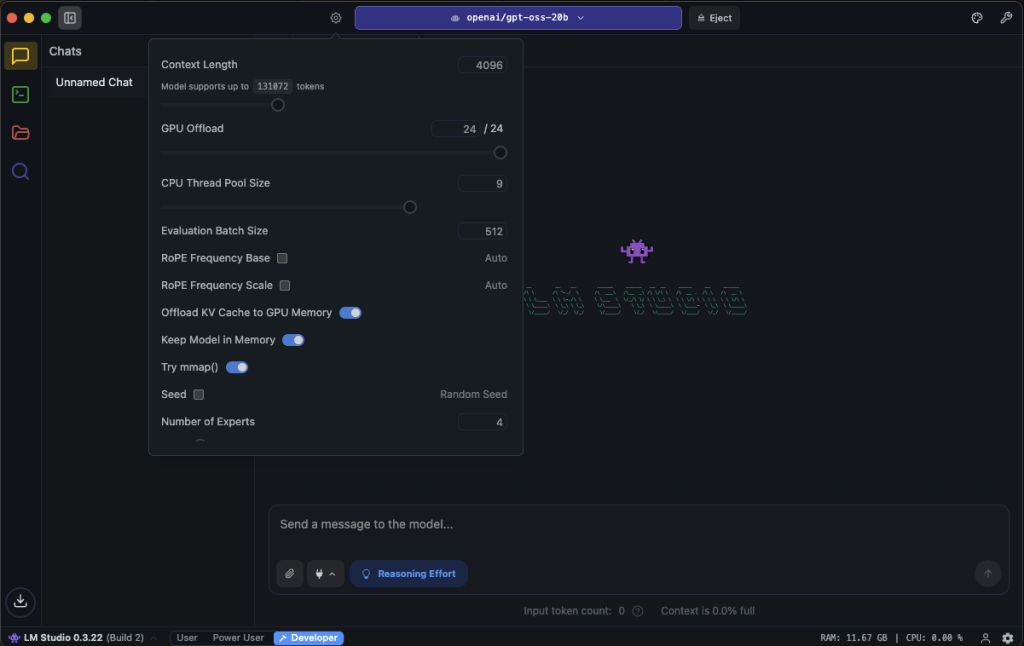

歯車マークから、トークン数などを変更できます。デフォルトでは4096が設定されています。動かし方は、一般的なチャットアプリと同じです。

実際に実行した際のリソース使用状況は、CPUが5〜7%、メモリが約12GBでした。

APIを立てる

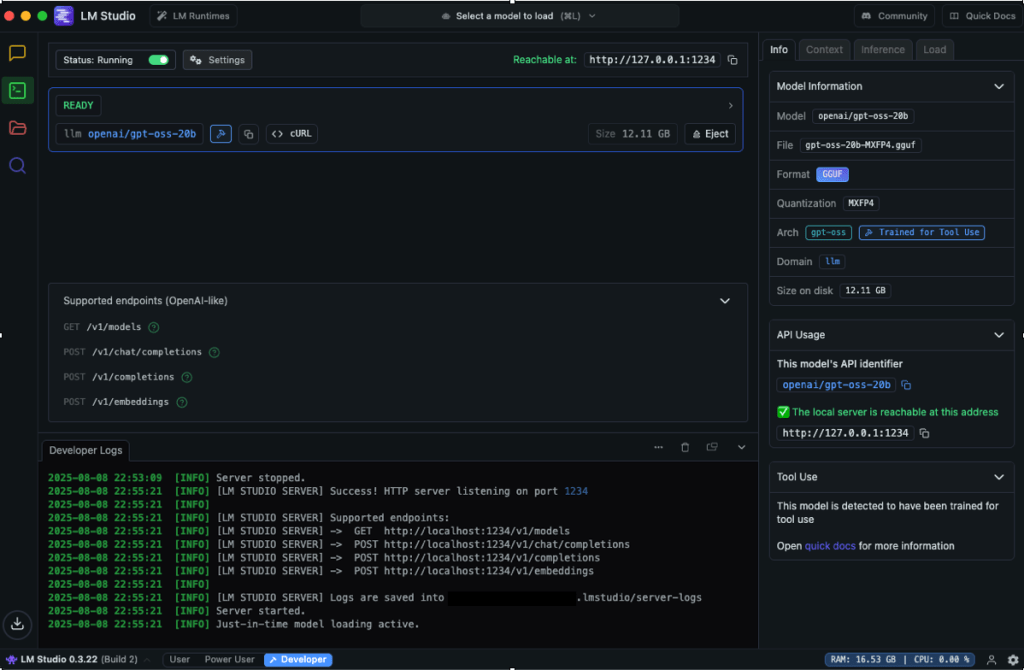

左側のメニューから、Developerに移動します。

そして、「Status: Stopped」のボタンをONにするとAPIが立ち上がります。

APIは4つ用意されています。

- GET /v1/models

- POST /v1/chat/completions

- POST /v1/embeddings

- POST /v1/completions

https://lmstudio.ai/docs/app/api/endpoints/openai

curlでのリクエスト例

|

1 2 3 4 5 6 7 8 9 10 11 |

$ curl http://localhost:1234/v1/chat/completions \ -H "Content-Type: application/json" \ -d '{ "model": "openai/gpt-oss-20b", "messages": [ { "role": "user", "content": "リクエストしたい内容" } ], "temperature": 0.7, "max_tokens": -1, "stream": false }' |

コーディングツールのAPIとしても使用できますが、gpt-oss-20bではまだ力不足な面を感じました。コーディングで使用する際は、通常通り各社が提供しているAPIや別のモデルを使うのが良さそうです。

まとめ

LM Studioを使ってみたところ、予想以上にスムーズに環境構築ができました。今はまだローカルLLMの使い道を探している段階ですが、面白いことができないか試していきたいと思います。少しでも参考になれば嬉しいです!

2000年生まれ、2022年4月からSaaS企業にエンジニアとして入社。主にバックエンドの開発、運用やDBのクエリチューニングなどを行う。@adachin0817へのキャリア相談をきっかけにTechBullコミュニティに参加。バックエンドやデータベースに興味があり、日々勉強中。